"בדומה לאירופה, צריכים להיות מקרים שבהם נאסור לגמרי על בינה מלאכותית"

על רקע ההתפתחויות הטכנולוגיות המהירות, בכל העולם עוסקים בשאלה כיצד צריכה להיראות הרגולציה על הבינה המלאכותית. בצל פגישתם של נתניהו עם מאסק והדיון של בכירי הטק בסנאט האמריקאי, ביררנו עם מומחים בנושא מה המצב היום בישראל, מה הסכנות של ה-AI ואיך צריכות להיראות לדעתם ההגבלות

בשבוע שעבר נערכה פגישה יוצאת דופן בסנאט האמריקאי עם כמה מהשמות הגדולים בעולם הטק: אילון מאסק מנכ"ל טסלה וספייס איקס, מארק צוקרברג מנכ"ל מטא, מנכ"ל גוגל, סונדר פיצ'אי, מנכ"ל מיקרוסופט לשעבר ביל גייטס ומנכ"ל מיקרוסופט הנוכחי סאטיה נאדלה ועוד.

מטרת הפגישה הנדירה, שאורגנה על ידי יו"ר הרוב בסנאט האמריקאי צ'אק שומר, הייתה דיון באפשרויות הרגולציה על תחום הבינה המלאכותית. לפי דיווח של הוול סטריט ג׳ורנל, רוב הנוכחים בפגישה הסכימו כי הממשלה צריכה להתערב ולהשית אסדרה על התחום. גם בפגישתו של ראש הממשלה נתניהו עם מאסק השבוע הבהיר המיליארדר האמריקני כי "אנחנו רוצים לוודא שהטכנולוגיה נשארת לטובת האנושות". בתגובה על כך אמר נתניהו: "AI עלולה להוביל למלחמות, גם לסוף הדמוקרטיה".

כנראה שיש הסכמה גורפת על כך שצריך להיות פיקוח על הבינה המלאכותית, אבל איך הוא צריך להיראות בישראל? ומה קורה בעולם? שאלנו כמה מומחים בתחום.

על פי יפית פורת, היועצת המשפטית הראשית של נטורל אינטליג'נס, קיים מתח מובנה בין הרצון לאפשר לטכנולוגיה להתרחב ולעודד חדשנות ובין הרצון לאסדרתה על מנת שלא יעשה בה שימוש לרעה. הגישה האירופאית דוגלת באסדרה רוחבית ומקיפה תוך חלוקת השימוש לשכבות סיכון. ארה"ב לעומת זאת, בוחרת בנקיטת צעדים רכים יותר - גם בשל הרצון בפיתוח טכנולוגי מואץ שלא יעוכב באמצעות חקיקה או רגולציה כבדה, אבל גם, ככל הנראה, כי מעצמות בהן אין אסדרה רוחבית כמו סין נושפות בעורפה בעולמות הטכנולוגיים בכלל ובעולמות הבינה המלאכותית בפרט.

"ישראל נוטה בשלב זה לכיוון הגישה האמריקאית בחקיקה סקטוריאלית ולא רוחבית. ככל הנראה, הפיקוח במקרה כזה יהיה בידי כל רגולטור בתחומו, ולכן מטבע הדברים, יהיו כאלו שיחמירו וינהגו בשמרנות יותר מאשר אחרים", אומרת פורת. "כך לדוגמה, כולנו כחברה נעדיף שבינה מלאכותית שמיושמת לצורך אבחון רפואי תהיה מפוקחת באופן הדוק, שכן נרצה להימנע מטעויות של חיים ומוות. יתרונה העיקרי של חקיקה סקטוריאלית הוא שהיא לוקחת בחשבון את הייחודיות הספציפית של התחום אותו היא מסדירה. מצד שני, פוטנציאל הבלבול, חוסר האחידות וההתנגשות בין הוראות הוא גבוה ויידרש פורום אחד שכולל אנשי טכנולוגיה, משפט, אתיקה כדומה על מנת לייצר קו אחיד בין הסקטורים השונים".

"בסקאלה שבין הגנה מחמירה, כפי שעושים באירופה, לבין מתן חופש לשוק להכתיב את הכללים, כפי שנוהגת ארה"ב, לישראל יש מקום מיוחד עם מאפיינים ייחודיים. קודם כל, אנחנו מדינה קטנה ומוטת מו"פ, מחקר ופיתוח, ויש לנו אינטרס גדול להוביל במרוץ העולמי ולהפוך ל-AI ניישן", מוסיפה עו"ד גאיה הררי הייט, ראש תחום מדיניות ורגולציה במכון SNPI. "עדיף לנו אם כן לראות לאן העולם לוקח את שאלת הרגולציה, ולא להיות הראשונים שממהרים להטיל הגבלות מחמירות ומרחיקות לכת על התפתחות הטכנולוגיה.

"מאפיין נוסף בישראל הוא המבנה המשטרי וחוסר היציבות הפוליטי והחברתי, שמקשים על העברת שינויים בחקיקה בכנסת, אפילו במקרים שבהם הסוגיה שעל הפרק לא שנויה במחלוקת. טכנולוגיות מתפתחות תמיד בקצב מהיר יותר מהרגולציה, ובשנים האחרונות ראינו לא פעם שכמעט כל סוגיה שמגיעה לפתחה של הכנסת, הופכת לכלי התנצחות פוליטי, ושחוקים חשובים נגררים שנים ונתקעים בכנסת מסיבות לא ענייניות, למשל, דיני הגנת הפרטיות".

באוקטובר 2022 פרסמה שרת החדשנות הקודמת, אורית פרקש הכהן, מסמך למדיניות להערות הציבור תחת הכותרת "מדיניות רגולציה ואתיקה בתחום הבינה המלאכותית", ממנו ברור, כך על פי פורת, כי אין כוונה לרגולציה מקיפה כמו באירופה.

הררי הייט מציינת כי היא תומכת באותו מסמך עקרונות שפורסם. "ישראל צריכה לבחור ברגולציה חכמה, סקטוריאלית וגמישה. כלומר, לא לבחור בחוק בינה מלאכותית בכנסת שיהיה קשה לעדכן בהתאם להתפתחויות הטכנולוגיות, אלא לקבוע שכל רגולטור יפקח בתחומו. הרגולטור משתנה בהתאם לתחום שאנחנו מדברים עליו. אם נדבר על הכנסה של בינה מלאכותית לבריאות - הרגולטור הוא משרד הבריאות. אם מדברים על חינוך - משרד החינוך. בתחבורה - משרד התחבורה. במערכת המשפט - משרד המשפטים או לשכת עורכי הדין. זה תלוי סקטור. לצד זה יוקם מוקד 'על משרדי', שיסייע לרגולטורים לעשות עבודה טובה, ושייצר הרמוניה ושפה אחידה בין הרגולטורים השונים, תוך שיתוף של התעשייה והאקדמיה בתהליכי הרגולציה", היא אומרת.

אבל מה הן בעצם הסכנות של פיתוח בינה מלאכותית ללא הגבלות? פורת מונה 5 עיקריות.

- אפליה – מחקרים רבים מהשנים האחרונות מוכיחים כי בני אדם נוטים להטיות כלפי אוכלוסיות מסוימות. לכאורה, השימוש במערכות מבוססות בינה מלאכותית יכול היה למתן את ההטיות האנושיות, אבל למרות זאת, בשל אפשרות להטיה בנתונים המשמשים לאימון המערכות, כגון מאגרי מידע לא ייצוגיים המשקפים אפליה קיימת, ישנו סיכוי להטיות לא מודעות באופן נרחב.

- הסברתיות - מאחר שבינה מלאכותית מבוססת על יכולות חישוביות היוצרות מודל חיזוי וקבלת החלטות שאינן ידועות לנו, כי למשל מי שאימן אותה כתב את התשובות הראשוניות ודירג את התשובות שנוצרו בעקבותיהן במהלך אימון המערכת בהתאם לסולם הערכים המסוים שלו, אז נפגעת היכולת שלנו להסביר את החלטות המערכת. באופן זה נפגעת היכולת לזהות כשלים אחרים, כמו לדוגמה האפליה אותה הזכרנו קודם.

- אבטחה וניצול לרעה - קיים חשש לתלות גבוהה במערכות שיחליפו אנשים או "שירדימו" אנשים, כך שכשמערכת תסבול מביצועים ירודים משום שאינה מסוגלת לבצע כהלכה את המשימה שיועדה לה, לא נהיה ערים מספיק לשגיאות או 'הזיות'. כך לדוגמה, קיימים מקרים מתועדים רבים של אנשים שצייתו באופן אוטומטי להנחיות תוכנת הניווט וויז עד כדי נסיעה לתוך קירות, מעבר לצוק ולתוך אגם מים.

כמו כן, ישנו חשש שגורם חיצוני ישבש את פעילותה של המערכת על ידי ניצול של נקודת תורפה הטבועה בה. סיכונים אלו מקבלים משנה תוקף בעולמות הבינה המלאכותית בעיקר לאור ההנגשה של המערכות לכל אדם, והעובדה שהן התאמנו על ולמדו גם תכנים שנחשבים זדוניים ופוגעניים. תכנים אלה מונגשים בצורה שלא הייתה זמינה בעבר. כך לדוגמה היכולת לעשות שימוש בטכנולוגית בינה מלאכותית ג'נרטיבית לצורך כתיבת קוד רוגלה או הכנת פצצה יהיה קל מתמיד גם עבור אדם שמעולם לא כתב פיסת קוד או הכין פצצה. - אחריותיות – ככל שהמעורבות האנושית בהחלטה מצטמצמת והמערכות פועלות באופן אוטונומי, עולה שאלת האחריות ומה החוק המתאים לבחינת שאלת האחריות (הדין הנזיקי, הדין הפלילי). הבעיה מחריפה כשיש שרשרת אחריות (downstream developer), כך לדוגמה כשיש מפתח אפליקציית מסחר שמתבססת על GPT, ואז נשאלת השאלה האם חברת OpenAI יכולה להמשיך ולטעון לאספקת מוצר AS IS, ולמעשה להותיר את המשתמש בתוכנת המסחר ללא גוף שניתן לפנות אליו.

- פרטיות – פיתוח ושימוש במערכות מבוססות בינה מלאכותית ככלל מצריך שימוש בנתונים רבים, שחלקם עשויים לכלול מידע אישי, ולהיות מוסדרים באמצעות דיני הגנת הפרטיות. לפיכך, עשויים להתעורר אתגרים ייחודיים הנוגעים לצורך להבטיח את ההגנה הנדרשת לזכות לפרטיות. כך למשל, לעיתים מבוקש "לאמן" מערכת במידע שנאסף למטרות אחרות. בנוסף, השימוש במערכות מבוססות בינה מלאכותית עלול ליצור מתח בין הצורך בנתוני ענק (Big Data) לבין מחיקת מידע עודף בהתאם לעיקרון צמצום המידע. קיים גם חשש שייעשה שימוש במערכות אלה לשם זיהוי חוזר של מידע שעבר התממה (אנונימיזציה), כלומר שהושמטו ממנו כבר פרטים מזהים של אנשים.

יפית פורת, היועצת המשפטית הראשית של נטורל אינטליג'נס | צילום: ענבל מרמרי

מה צריכות להיות ההגבלות?

הררי הייט: "באירופה הלכו על מודל מעניין של שיטת רמזור – ההגבלה והדרישות הן בהתאם לרמת הסיכון. לא דין אפליקציה לתמונות כדין טכנולוגיה שקובעת האם תקבל הלוואה בבנק. לדעתי, זאת מסגרת מאוד נכונה לחשוב על הנושא. אחד הנושאים העיקריים שמדברים עליהם בהקשר של הגבלות ופיתוח של בינה מלאכותית אחראית (Responsible AI) הוא הנושא של שקיפות והסברתיות, וחשוב לדרוש את זה כל שלבי הייצור: בשלב האימון של המכונה (הסברתיות של הדאטה, זיהוי טרנדים בתוך הדאטה ולדעת לזהות הטיות ובפרט הפליה של קבוצות מסוימות) וכן הסברתיות בשלב התוצאה – לדעת לנטר החלטה ספציפית ולהבין למה היא התקבלה.

בנוסף, צריכים להיות כללים ברורים לגבי שמירה על פרטיות ובטיחות של המכונה. בדומה לאירופה, אני גם חושבת שצריכים להיות מקרים שבהם נאסור לגמרי על בינה מלאכותית – במקרים המאוד מאוד רגישים שיש להם השפעה על חיי אדם, וזה נכון גם ואפילו בעיקר לשימוש של הממשלות עצמן בכלים האלה".

פורת: "במודל האירופאי ישנה חלוקה לארבע שכבות של רמות סיכון: בלתי קביל, גבוה, מוגבל ומינימלי. כלומר, ישנה התייחסות בטיוטת החוק לסיכוני השימוש ולא הגבלות ביחס לבינה המלאכותית כשלעצמה. קביעת מדרג גורמי סיכון מאפשרת התמקדות בתחומים הרגישים בכל סקטור ולא התייחסות לכל שימושי הבינה המלאכותית כמקשה אחת.

"לאחר מיפוי הסיכונים יש לקבוע מגבלות טכנולוגיות בהתאם לרמת הסיכון - כך למשל, סיכון שנחשב גבוה ברמת בלתי-קביל, שיש בשימוש בו פגיעה ממשית בזכויות יסוד של פרט, ייאסר לשימוש, בעוד שטכנולוגיות אחרות בעלות רמת סיכון גבוה או מוגבל יידרשו להפעלת בקרות שונות, גילוים ואף חותמות דיגיטליות.

"חשוב מאוד כי הרגולציה בישראל ביחס לפיתוח ושימוש בבינה מלאכותית, ככל שתאומץ, תביא בחשבון את הרגולציה הנוהגת בתחום ושאומצה על ידי ארגונים בינלאומיים, ותותאם במידת האפשר לרגולציה רלוונטית שנקבעה במדינות ובארגונים כאמור. זאת, בין היתר, כדי להימנע מהצבת חסמים רגולטוריים ייחודיים בפני כניסת מערכות מבוססות בינה מלאכותית לישראל.

"אני עצמי מברכת על פיקוח משמעותי בתחום שנושא בתוכו אינספור סיכונים ושבכל מקרה יידרש ליישר קו עם חקיקה אירופאית כפי שנעשה בתחום הפרטיות, על מנת שמעמדה של ישראל כמובילה טכנולוגית לא יהפוך במהרה למקלט לטכנולוגיות זדוניות. לפיכך, קידום רגולציה שמטרתה להסדיר פיתוח ושימוש בבינה מלאכותית הוא מבורך וככל שהנטייה היא לאסדרה סקטוריאלית, רצוי שהדבר ייעשה ברמת הענף שבו היא נדרשת, בהובלת הרגולטור האמון עליו ובשיתוף מומחים מדיסציפלינות שונות".

"הייתי מציע לחשוב על זה כמו על ענף התחבורה. כמו שישנה רגולציה על כלי רכב, על תשתיות התחבורה ועל הנהגים עצמם, רגולציה ב-AI צריכה להיות על יצרניות הכלים כמו ChatGPT, יצרניות המידע (כל חברות הדאטה שנאסף), ועל המשתמשים עצמם", מוסיף עמרי קוהל, מייסד ומנכ"ל פירמיד אנליטיקס. "ההגבלות צריכות להיות בהתאם לשימוש עצמו ולגוף שעושה בו שימוש. יש להבחין בין צרכנים פרטיים, מסחריים וממשלתיים. אותה הבחנה רצוי לבצע גם ליצרני כלי ה-AI".

"גודל הסכנות בפיתוח בינה מלאכותית ללא הגבלות הוא כגודל ההשפעה שלה - מהפכת הבינה המלאכותית כבר כאן, ומומחים בתחומים שונים צופים שהשפעה שלה תהיה על כל אחד ואחד מתחומי החיים שלנו", מסכמת הררי רייט. "זאת המהפכה התעשייתית של דורנו, ואנחנו כבר עכשיו רואים שלצד הפוטנציאל האדיר, היא מביאה איתה סיכונים – להפליה, להחלטת שגויות, להסתמכות גדולה מדי של אנשים על הטכנולוגיה, לשיבוש שווקים ומקצועות, לפגיעה בפרטיות, ועוד ועוד. הטכנולוגיה הזו תשנה את העולם, אבל זאת אחריות שלנו שהיא תשנה אותו לטובה. ואנחנו בנקודת הזמן שבה צריך לבחור לעצב אותה בצורה טובה, אחראית ושיוונית לכולם".

ומה לגבי זכויות יוצרים? בארה"ב החליט לאחרונה בית המשפט שאין זכויות יוצרים למי שיצר תמונה בבינה מלאכותית.

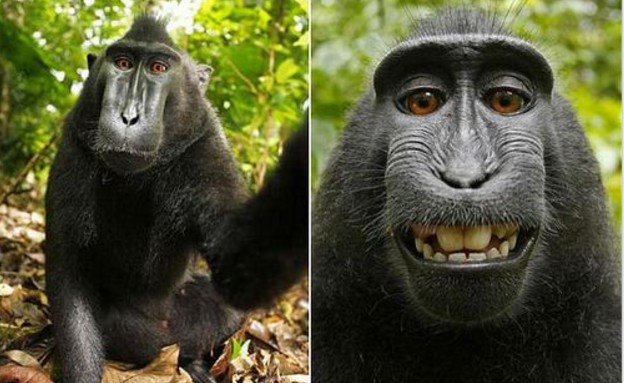

הררי רייט: "מדובר בהחלטה של שופטת בית משפט מחוזי במחוז קולומביה בארה"ב. זאת החלטה מעניינת וחשובה, אבל השאלה הזו רחוקה מהכרעה סופית, ויכול להיות שבהמשך נראה פסקי דין שקובעים אחרת, בארה"ב או בארץ. הפסיקה הזו היא המשך של הרעיון המקובל ש'היצירה האנושית היא דרישת יסוד של זכויות יוצרים', סוגיה שהתעוררה בעבר עם תמונת הקוף שצילם את עצמו, תמונה שזכתה להצלחה רבה ועוררה שאלות מעניינות בתחום זכויות היוצרים.

"יש בעיקרון הזה גם היגיון רב – המאמץ האנושי, היזע, היצירתיות, הם אלה שאנחנו רוצים להגן עליהם ולעודד אותם. אם המאמץ ירד בצורה משמעותית, יכול להיות שגם האינטרס או המוטיבציה להגן עליהם בקנאות ירד, ואנחנו נגיע למציאות שבה יש הרבה יותר מידע ויצירה 'חופשיים', ושכל התפיסה שלנו לגבי תוכן, הזמינות שלו והצריכה שלו תשתנה. בכל אופן, אנחנו עוד רחוקים משם, וכרגע מקובל לחשוב שבינה מלאכותית לא בהכרח תחליף בעלי מקצוע, אבל בעלי מקצוע שיודעים איך למנף אותה ולעשות בה שימוש - יחליפו את אלו שלא".